说说deepseek的训练逻辑(只是推测,没有实锤)

deepseek训练数据来源的合法性:

根据deepseek v2发布时间和gpt3.5 降价时间线来看。

当gpt3.5白菜价之后(3.5近乎不要钱的时候)deepseek v2发布了。

可以推测deepseek v2是用了gpt3.5训练的,v2是复刻3.5模型。而deepseek母公司有gpu的优势,有大量显卡库存,所以v2才能有那么低的价格发布!

结论:数据来源的合法性,这个也没有好说,细究下,从openai 到谷歌,大家训练数据来源的合法性都有问题!

以此类推:

deepseek v3 使用了gpt4o训练吗?还是用的自己家的v2训练的?

可疑之处就在于:v3 发布也是在gpt4o大降价后,不得让人怀疑,v3的数据来源是不是gpt4o?

先模仿后超越!r1是用的o1模型训练,还是用的自己家的v3训练的?

r1发布时间在o1发布1个月左右,deepseek团队似乎已经掌握了快速复刻对方模型能力。复刻的效率越来越高了!所以r1是复刻o1吗?

当然不排除r1是在自家v3模型基础上训练出来的!

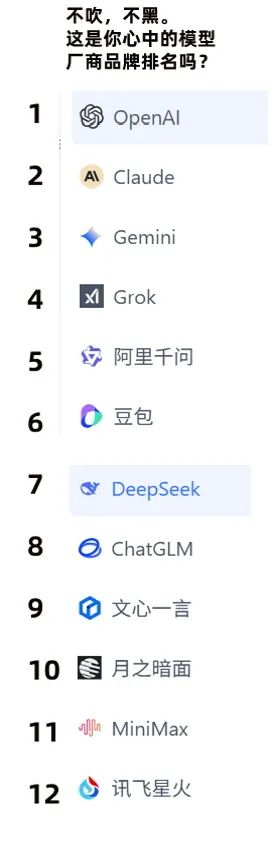

为什么deepseek的排名不高,核心原因是tob用户的体验,如果从体验上看,deepseek复刻别人模型的概率很大!

复刻模型在模型丰富度上,不如原模型,也就是在个人用起来还行,如果是很多人用的时候,bug的容错率就低了。

换句话说,toB的开发人员不会用复刻模型做开发,因为容错率不如原生模型!

所以deepseek的排名不高,不作为首选模型列表!